Η Apple θα σαρώνει τις βιβλιοθήκες φωτογραφιών των iPhone για την προστασία των παιδιών

Η Apple ανακοίνωσε ότι λαμβάνει μέτρα για να προστατέψει τα παιδιά από όσους προσπαθούν να τα εκμεταλλευτούν και να μειώσει την διάδοση υλικού σεξουαλικής κακοποίησης παιδιών (CSAM=Child Sexual Abuse Material).

Συγκεκριμένα η αμερικανική εταιρεία θα εισάγει νέες δυνατότητες ασφάλειας για τα παιδιά σε τρεις τομείς, οι οποίες αναπτύχθηκαν σε συνεργασία με ειδικούς για την ασφάλεια των παιδιών.

Πρώτον, τα νέα εργαλεία επικοινωνίας θα επιτρέψουν στους γονείς να διαδραματίσουν έναν πιο αναβαθμισμένο ρόλο βοηθώντας τα παιδιά τους να επικοινωνούν στο διαδίκτυο. Η εφαρμογή Messages/ Μηνύματα θα χρησιμοποιεί τεχνολογία τεχνητής νοημοσύνης με μηχανική εκμάθηση για να προειδοποιεί για ευαίσθητο περιεχόμενο, διατηρώντας παράλληλα τις ιδιωτικές επικοινωνίες μη αναγνώσιμες από την Apple. Η εφαρμογή θα αποκτήσει νέα εργαλεία για να προειδοποιήσει τα παιδιά και τους γονείς τους όταν λαμβάνουν ή στέλνουν σεξουαλικά άσεμνες φωτογραφίες. Κατά τη λήψη αυτού του τύπου περιεχομένου, η φωτογραφία θα θολώσει και το παιδί θα προειδοποιηθεί και θα διαβεβαιωθεί ότι είναι εντάξει αν δεν θέλει να δει αυτήν τη φωτογραφία. Ως πρόσθετη προφύλαξη οι γονείς του παιδιού θα λάβουν ένα μήνυμα αν το παιδί επιλέξει να δει την φωτογραφία. Παρόμοια μέτρα προστασίας είναι διαθέσιμα εάν ένα παιδί επιχειρήσει να στείλει φωτογραφίες με σεξουαλικό περιεχόμενο. Το παιδί θα ειδοποιηθεί πριν αποσταλεί η φωτογραφία και οι γονείς θα μπορούν να λάβουν ένα μήνυμα εάν το παιδί επιλέξει να την στείλει. Το Messages θα χρησιμοποιεί τεχνητή νοημοσύνη στη συσκευή για την ανάλυση συνημμένων εικόνων και τον προσδιορισμό αν μια φωτογραφία είναι σεξουαλικά απρεπής. Η λειτουργία έχει σχεδιαστεί έτσι ώστε η Apple να μην έχει πρόσβαση στα μηνύματα.

Επιπλέον τα iOS και iPadOS θα εξοπλιστούν με νέες εφαρμογές κρυπτογράφησης για να περιορίσουν την εξάπλωση του υλικού σεξουαλικής κακοποίησης παιδιών στο διαδίκτυο, ενώ θα είναι σχεδιασμένες για το απόρρητο των χρηστών. Η ανίχνευση CSAM θα βοηθήσει την Apple να παρέχει πολύτιμες πληροφορίες στις αρχές σχετικά με τις συλλογές CSAM στο iCloud Photos.

Η Apple προχώρησε ένα βήμα παραπάνω εξηγώντας πως θα λειτουργει η ανίχνευση υλικού σεξουαλικής κακοποίησης παιδιών. Η μέθοδος της Apple για τον εντοπισμό υλικού σεξουαλικής κακοποίησης παιδιών (CSAM) έχει σχεδιαστεί με γνώμονα την ιδιωτικότητα του χρήστη. Αντί για σάρωση εικόνων στο cloud, το σύστημα εκτελεί έρευνα στη συσκευή χρησιμοποιώντας μια βάση δεδομένων με γνωστές εικόνες CSAM που παρέχονται από το National Center for Missing and Exploited Children (NCMEC) και άλλους οργανισμούς ασφάλειας παιδιών. Η Apple μετατρέπει περαιτέρω αυτήν τη βάση δεδομένων σε ένα αδιάβαστο σύνολο μίγματος εικόνων που αποθηκεύεται με ασφάλεια στις συσκευές των χρηστών.

Πριν από την αποθήκευση μιας εικόνας στο iCloud Photos, πραγματοποιείται μια διαδικασία ανίχνευσης στη συσκευή για αυτήν την εικόνα έναντι των γνωστών εικόνων CSAM. Αυτή η διαδικασία έρευνας υποστηρίζεται από μια κρυπτογραφική τεχνολογία που ονομάζεται private set intersection, η οποία καθορίζει εάν υπάρχει αντιστοιχία χωρίς να αποκαλυφθεί το αποτέλεσμα. Η συσκευή δημιουργεί ένα κρυπτογραφικό κουπόνι ασφαλείας που κωδικοποιεί το αποτέλεσμα αντιστοίχισης μαζί με επιπλέον κρυπτογραφημένα δεδομένα για την εικόνα. Αυτό το κουπόνι γίνεται upload στο iCloud Photos μαζί με την εικόνα.

Χρησιμοποιώντας μια άλλη τεχνολογία που ονομάζεται threshold secret sharing, το σύστημα διασφαλίζει ότι τα περιεχόμενα των κουπονιών ασφαλείας δεν μπορούν να διαβαστούν από την Apple, εκτός εάν ο λογαριασμός iCloud Photos ξεπεράσει ένα όριο γνωστού περιεχομένου υλικού σεξουαλικής κακοποίησης παιδιών. Το όριο έχει οριστεί να παρέχει ένα εξαιρετικά υψηλό επίπεδο ακρίβειας και εξασφαλίζει λιγότερη από μία στο ένα τρισεκατομμύριο πιθανότητες, ετησίως, να επισημάνει εσφαλμένα έναν λογαριασμό.

Μόνο όταν ξεπεραστεί το όριο, η τεχνολογία κρυπτογράφησης επιτρέπει στην Apple να ερμηνεύσει το περιεχόμενο των κουπονιών ασφαλείας που σχετίζονται με τις αντίστοιχες εικόνες υλικού σεξουαλικής κακοποίησης παιδιών . Στη συνέχεια, η Apple εξετάζει χειροκίνητα κάθε αναφορά για να επιβεβαιώσει ότι υπάρχει αντιστοίχιση, απενεργοποιεί τον λογαριασμό του χρήστη και στέλνει μια αναφορά στο NCMEC. Εάν ένας χρήστης πιστεύει ότι ο λογαριασμός του έχει επισημανθεί κατά λάθος, μπορεί να υποβάλει αίτημα επανεξέτασης για την επαναφορά του λογαριασμού του. Αυτή η καινοτόμος νέα τεχνολογία επιτρέπει στην Apple να παρέχει πολύτιμες και εύχρηστες πληροφορίες στο NCMEC και την επιβολή του νόμου σχετικά με τον πολλαπλασιασμό υλικού CSAM. Και το κάνει ενώ παρέχει σημαντικά οφέλη απορρήτου σε σχέση με τις υπάρχουσες τεχνικές, καθώς η Apple μαθαίνει για τις φωτογραφίες των χρηστών μόνο εάν έχουν μια συλλογή γνωστών CSAM στο λογαριασμό τους στο iCloud Photos. Ακόμη και σε αυτές τις περιπτώσεις, η Apple μαθαίνει μόνο για εικόνες που ταιριάζουν με το γνωστό υλικό CSAM.

Τέλος, οι ενημερώσεις σε Siri και το Search θα παρέχουν στους γονείς και στα παιδιά διευρυμένες πληροφορίες και βοήθεια εάν αντιμετωπίσουν μη ασφαλείς καταστάσεις. Για παράδειγμα, οι χρήστες που ρωτούν τη Siri πώς μπορούν να αναφέρουν υλικό σεξουαλικής κακοποίησης παιδιών ή την εκμετάλλευση παιδιών, θα υποδεικνύονται σε πόρους για το πού και πώς να υποβάλουν μια αναφορά. Το Siri και το Search θα παρεμβαίνουν επίσης όταν οι χρήστες προσπαθούν να αναζητήσουν θέματα που σχετίζονται με υλικό σεξουαλικής κακοποίησης παιδιών. Αυτές οι παρεμβάσεις θα εξηγούν στους χρήστες ότι το ενδιαφέρον για αυτό το θέμα είναι επιβλαβές και προβληματικό και θα παράσχουν πόρους από συνεργάτες για να λάβουν βοήθεια σε αυτό το θέμα.

Οι παραπάνω νέες λειτουργίες της Appla αναμένεται αν είναι διαθέσιμες μέσα στο 2021, με ενημερώσεις για τα iOS 15, iPadOS 15, watchOS 8 και macOS Monterey.

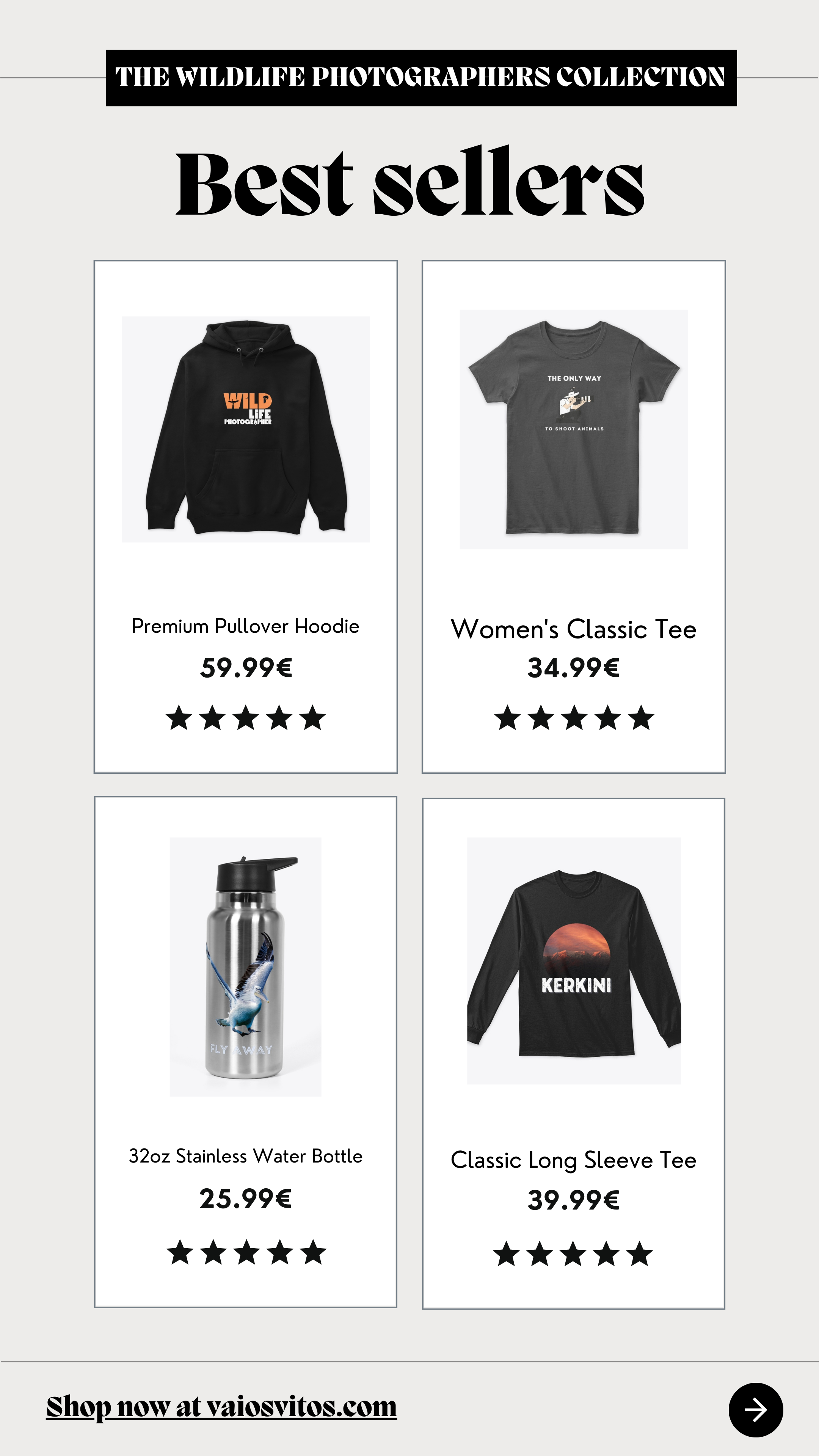

Αναζητήστε όλα τα νέα προϊόντα στο κατάστημα

Ρεπέλλα Φωτογραφικά.

To pttlgr στηρίζεται για την λειτουργία του στους αναγνώστες του!

Μπορείς να βοηθήσεις με μία μικρή δωρεά!

Υποστηρίξτε το pttlgr ακόμα και με μόλις 1€ – χρειάζεται μόνο ένα λεπτό. Εάν μπορείτε, σκεφτείτε να μας υποστηρίξετε με ένα ποσό κάθε μήνα.

Σας ευχαριστούμε.

Στηρίξτε το pttlgr και την προσπάθεια μας για έγκυρη και άμεση ενημέρωση ακολουθώντας μας

σε Instagram, YouTube και Facebook!

Ακολουθήστε το pttlgr στα Google News, εδώ!

Πριν φύγετε δείτε

- Canon: Έδωσε το πράσινο φως στη Sigma για 6 νέους RF φακούς!

- A24: Κατηγορείται για χρήση AI εικόνων σε πόστερ της ταινίας Civil War!

- Αυτή η κάμερα μεταφράζει τις φωτογραφίες σε ποιήματα!

- Pergear: Κυκλοφόρησε ο νέος φακός 25mm f/1.7 με τιμή 72 ευρώ!

- Fujifilm XApp: Αναβαθμίστηκε και προσφέρει μεταφορά Raw αρχείων στο smartphone σου!

- Έρχεται η νέα Fujifilm X-T50;